Знаете, что на самом деле утомительно и скучно? Обучаем роботов схватывать кучу самых разных предметов. Вот почему робототехники вместо этого начали обращаться к стратегиям искусственного интеллекта, таким как самостоятельное обучение , когда вы позволяете роботу постепенно выяснять, как понимать вещи, снова и снова пробуя немного разные техники. Даже с большой грудой роботов это занимает много времени (по крайней мере , тысячи роботов-часов) , и хотя в конце вы можете получить очень хорошую обобщенную структуру понимания, в этой структуре нет очень хорошее представление о том, что такое хорошее понимание.

Проблема здесь в том, что в большинстве случаев эти методы измеряют захват двоичным способом с использованием очень простых датчиков: был ли объект поднят, а не уронен? Если так, захват объявляется успешным. В реальном мире схватывание не работает именно так, как может подтвердить большинство людей: просто потому, что что-то можно поднять, а не уронить, не обязательно означает, что вы поднимаете это лучше всего, или даже особенно хороший способ. А нестабильные, почти не работающие захваты означают, что падение объекта значительно более вероятно, особенно если произойдет что-то непредвиденное, что является удручающе обычным явлением за пределами лабораторий робототехники.

Помня об этом, исследователи из Университета Карнеги-Меллона и Google решили объединить теорию игр и глубокое обучение, чтобы улучшить понимание. Их идея заключалась в том, чтобы представить противника как часть процесса обучения — «злого робота», который делает все возможное, чтобы в остальном приемлемый захват не удался.

Концепция состязательного схватывания проста: все дело в попытках схватить что-то, в то время как что-то другое (противник, говоря языком исследований) затрудняет это:

Исследователи — Леррел Пинто , Джеймс Дэвидсон и Абхинав Гупта , представившие свою работу на Международной конференции IEEE по робототехнике и автоматизации ( ICRA) на прошлой неделе, — сформулировали свой состязательный подход как повторяющуюся игру двух игроков с нулевой суммой (популярный метод. из теории игр). В их модели каждый игрок представляет собой сверточную нейронную сеть, один пытается преуспеть в захвате, а другой пытается разрушить первого.

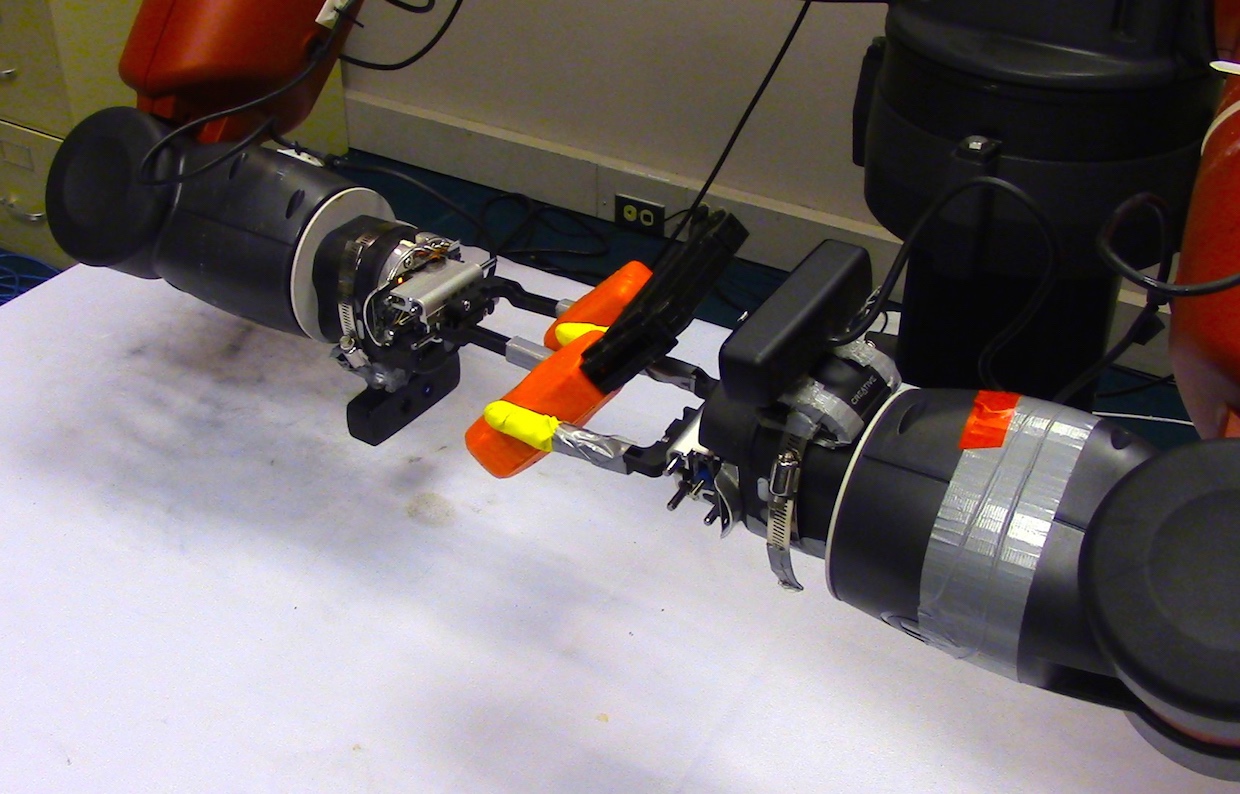

Такие вещи, как гравитация, инерция и трение (или отсутствие трения), являются основными противниками, с которыми хватающий робот должен постоянно иметь дело, но этот робот может затруднить захват для себя, встряхивая объект, когда он поднимает его. Это одна из приятных особенностей роботов: вы можете запрограммировать их с помощью враждебных альтер-эго, чтобы они могли мешать самим себе, будь то дрожание одной руки или использование второй руки, чтобы более непосредственно беспокоить первую, пытаясь чтобы вырвать объект.

Если противник успешен, это означает, что захват был плохим, и программа захвата извлекает уроки из этой неудачи. В то же время программа противника извлекает уроки из своего успеха, и вы в конечном итоге получаете своего рода эскалацию гонки вооружений, в которой и программа захвата, и программа противника все лучше и лучше выполняют свою работу. Вот почему это исследование является многообещающим для реальных приложений. Чтобы роботы были полезными, они должны работать в среде, где им постоянно приходится сталкиваться.

Исследователи продемонстрировали, что их состязательная стратегия может ускорить процесс обучения и привести к созданию более надежной системы, чем подход, который не полагается на противника. Они также показали, как это работает, гораздо лучше, чем просто пытаться использовать множество дополнительных захватов без противника:

После 3 итераций тренировки с трясущимся противником наш показатель схватывания улучшается с 43 до 58 процентов. Обратите внимание, что наша базовая сеть, которая не выполняет состязательное обучение, имеет показатель охвата всего 47 процентов. Это ясно указывает на то, что дополнительный надзор со стороны злоумышленника намного полезнее, чем просто сбор более точных данных. Что интересно, так это тот факт, что 6К примеров противников приводят к 52-процентному показателю схватывания (итерация 1), тогда как 16К дополнительных примеров схватывания дают только 47 процентов охвата. Это ясно показывает, что в случае нескольких роботов обучение с использованием состязательных настроек является более выгодной стратегией.

[Общий] результат — значительное улучшение по сравнению с исходным уровнем в схватывании новых предметов: увеличение общего показателя успеха схватывания до 82 процентов (по сравнению с 68 процентами, если не используется состязательная тренировка). Еще более драматично, если мы ограничили захват за счет уменьшения максимальной силы и контактного трения, метод достиг бы 65 процентов успеха (по сравнению с 47 процентами, если не использовалось состязательное обучение).

Часть уловки здесь заключается в том, чтобы сделать противника полезным, выбрав поведение, которое будет затруднительно (но не невозможно) для робота-захватчика. Вы можете сделать это, наблюдая, как не потревоженный захватывающий робот имеет тенденцию к отказу, а затем запрограммировав противника на то, чтобы нацелить этот режим отказа. Встряхивание и хватание, как правило, эффективны при работе с захватами, которые могут удерживать предметы, но нестабильны, поэтому роботы, которые учатся преодолевать их, становятся намного лучше в захвате в целом. В зависимости от типа вещей, которые вы хотите понять, и ситуаций, в которых вы хотите их понять, вы можете представить себе других противников, которые также будут эффективными учителями.